Reti neurali più robuste: un metodo per non ingannare l’intelligenza artificiale

Uno studio congiunto dell’Università di Trieste della Sissa e dell’Università di Oxford è riuscito a comprendere l’origine matematica della fragilità nella classificazione di oggetti da parte degli algoritmi e porvi rimedio

Una modificazione impercettibile all’occhio umano può ingannare sofisticate intelligenze artificiali facendogli compiere errori di classificazione che un essere umano non farebbe mai, come confondere un autobus con uno struzzo. Un problema significativo per la sicurezza quando si tratta di applicare il deep learning, le reti neurali profonde, a strumenti come le automobili che si guidano da sole. Un team di ricercatori e docenti targato Università di trieste, Scuola Internazionale Superiore di Studi Avanzati – Sissa con sede sempre nel capoluogo giuliano e Università di Oxford è riuscito però a mostrare una nuova via per rendere queste reti neurali più robuste e difficili da ingannare.

La studio, “Robustness of Bayesian Neural Networks to Gradient-Based Attacks”, i cui autori sono Ginevra Carbone, Matthew Wicker, Luca Laurenti, Andrea Patane, Luca Bortolussi, Guido Sanguinetti, è stato accettato dalla Conference on Neural Information Processing Systems, la principale conferenza sull’Artificial Intelligence.

Ciò attesta come, nell’ambito dell’area “data science”, relativamente nuova, si stiano consolidando collaborazioni di eccellenza in ambito regionale, con risultati già riconoscibili e risonanze in ambito internazionale.

Motivo di ulteriore considerazione è che il primo autore, Ginevra Carbone, sia una dottoranda dell’Università degli Studi di Trieste, una tra i primi studenti ad essersi laureata nella laurea magistrale interateneo in Data science and scientific computing. Come noto, non sono molte le donne ad intraprendere questo tipo di studi in questo ambito, e questo, quindi, è un risultato dalla duplice valenza.

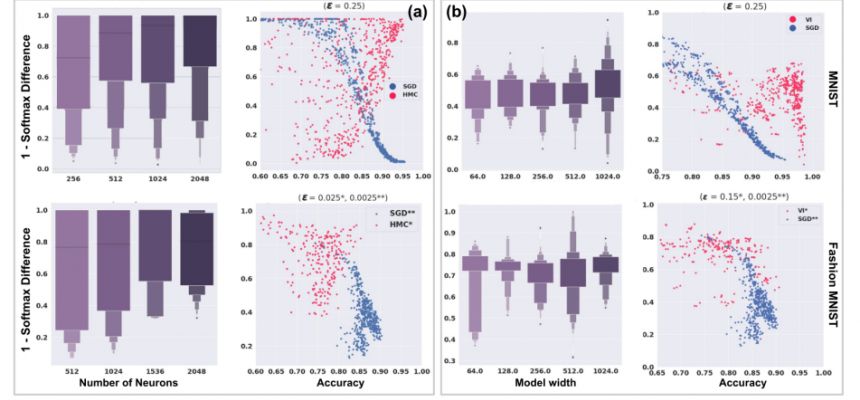

Le reti neurali profonde (deep learning) sono algoritmi fondamentali nell’intelligenza artificiale moderna, grazie alla loro capacità di riconoscere strutture complesse in masse di dati enormi. Un esempio lampante è la capacità di riconoscere oggetti in immagini naturali, o di tradurre (e generare) linguaggio. Ma queste reti possono essere ingannate : un hacker in possesso di alcune informazioni sulla rete (la cosiddetta loss function) può facilmente inserire piccole perturbazioni agli input, causando catastrofici fallimenti nelle predizioni della rete stessa. Ad esempio una modificazione di pochi pixel in un immagine può far classificare alla rete un autobus come uno struzzo, un tranello in cui un essere umano non cadrebbe mai. La vulnerabilità a questi “adversarial attacks”, è da anni un limite all’applicazione di questo tipo di reti ad applicazioni in cui la sicurezza è critica. Nella nuova ricerca, adottando un punto di vista geometrico e utilizzando risultati che provengono dalla fisica statistica, gli autori sono riusciti a capire e a dimostrare qual è l’origine matematica del problema e a dimostrare in alcuni casi può essere compensato usando tecniche Bayesiane, cioè utilizzando un insieme di reti statisticamente coerenti che hanno la capacità di compensarsi a vicenda nell’errore che commettono, diventando più robuste.

L'articolo è disponibile a questo link: https://arxiv.org/pdf/2002.04359.pdf

Va rilevato inoltre come anche alcuni blog di settore, di cui ai link sotto riportati, abbiano già ripreso, indipendentemente, il lavoro citato in termini molto lusinghieri:

https://statsandai.wordpress.com/2020/10/08/research-highlights-robustne...

https://www.programmersought.com/article/98695654326/